Natural Language Processing" (1) Curriculum - Overview and Hands-on Practice

Subject: Natural Language Processing (NLP)

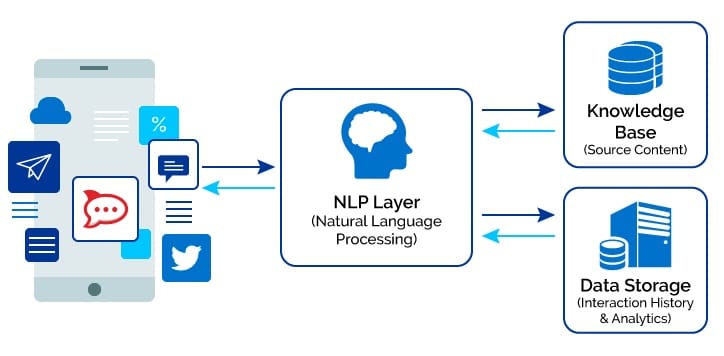

Through my work in implementing AI chatbots and taking the Natural Language Processing (NLP) course, I realized that since the introduction of the "Attention Is All You Need" paper and the breakthrough models like "Transformer", "BERT", and "GPT-2", there has been a significant increase in both corporate and academic interest in dialog systems such as AI chatbots and customer support services, with NLP technologies at their core.

This shift can be attributed to the advancements in NLP technologies, which have reached a point where natural language services are widely accepted without significant resistance.

In this context, I want to explore what Natural Language Processing (NLP) is, why the interest in it has grown rapidly, and what technologies have made this possible. Additionally, I will present the requirements and methods for developing AI services based on NLP technology.

Approach/Goal:

- Understanding NLP

- Developing an AI chatbot using BERT

- Timeline: From September 2020 onwards.

1. Overview

- AI vs Natural Language Processing

- SQuAD vs KorQuAD

2. Mathematical Background

3. Basics of Natural Language Processing

- NLP Steps

- Morphological Analysis

- Word Embedding

4. Language Models (LM)

- Definition of Models

- Markov Probability Model

- RNN (Recurrent Neural Network)

- Attention Models

- Self-Attention

- Multi-head Self-Attention Model

- Multi-head Self-Attention Encoder Model

5. Key Research Papers

- Background

- Feed Forward

- Softmax

- Positional Encoding

- BERT vs OpenAI GPT vs ELMo

- BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

- OpenAI GPT-1: Improving Language Understanding by Generative Pre-Training

- ELMo: Deep Contextualized Word Representations

6. Hands-on Practice (Environment Setup and Review of Trial-and-Error)

- Korean Morphological Analyzer

- Preprocessing

- Evaluation of Sequence Labeling

- Speech-to-Text (STT)

- Text-to-Speech (TTS)

- AI Chatbot

This curriculum provides a comprehensive introduction to NLP, its mathematical foundations, key models, and practical applications in areas like AI chatbots and speech processing.

Reference

- 서 적) 텐서플로 2 와 머신러닝으로 시작하는 자연어 처리

- 외부 강의 ) 자연어 언어모델 ‘BERT (Bidirectional Encoder Representations form Transformer)’ * T Academy & 솔트룩스 강의

- http://hunkim.github.io/ml/ 모두를 위한 머신러닝/딥러닝 강의 - 홍콩과기대 김성훈-

시즌 NLP - Deep NLP

(TBA)

Comments

Post a Comment